Телеграм канал «AI для Всех»

Главный редактор и по рекламе: @crimeacs

Иногда пишут в канал: @GingerSpacetail, @innovationitsme

телеграм-каналов

рекламных размещений, по приросту подписчиков,

ER, количеству просмотров на пост и другим метрикам

и креативы

а какие хуже, даже если их давно удалили

на канале, а какая зайдет на ура

Многие спрашивали а правда ли само, а как работает? Процесс такой: задаем общую тему (в моем случае полученные на основе того, что мы раньше показывали в рекламе и что заходит в целом). Дальше авторисерчер делает все сам - генерируют и иттерирует картинку, сюжет и видео.

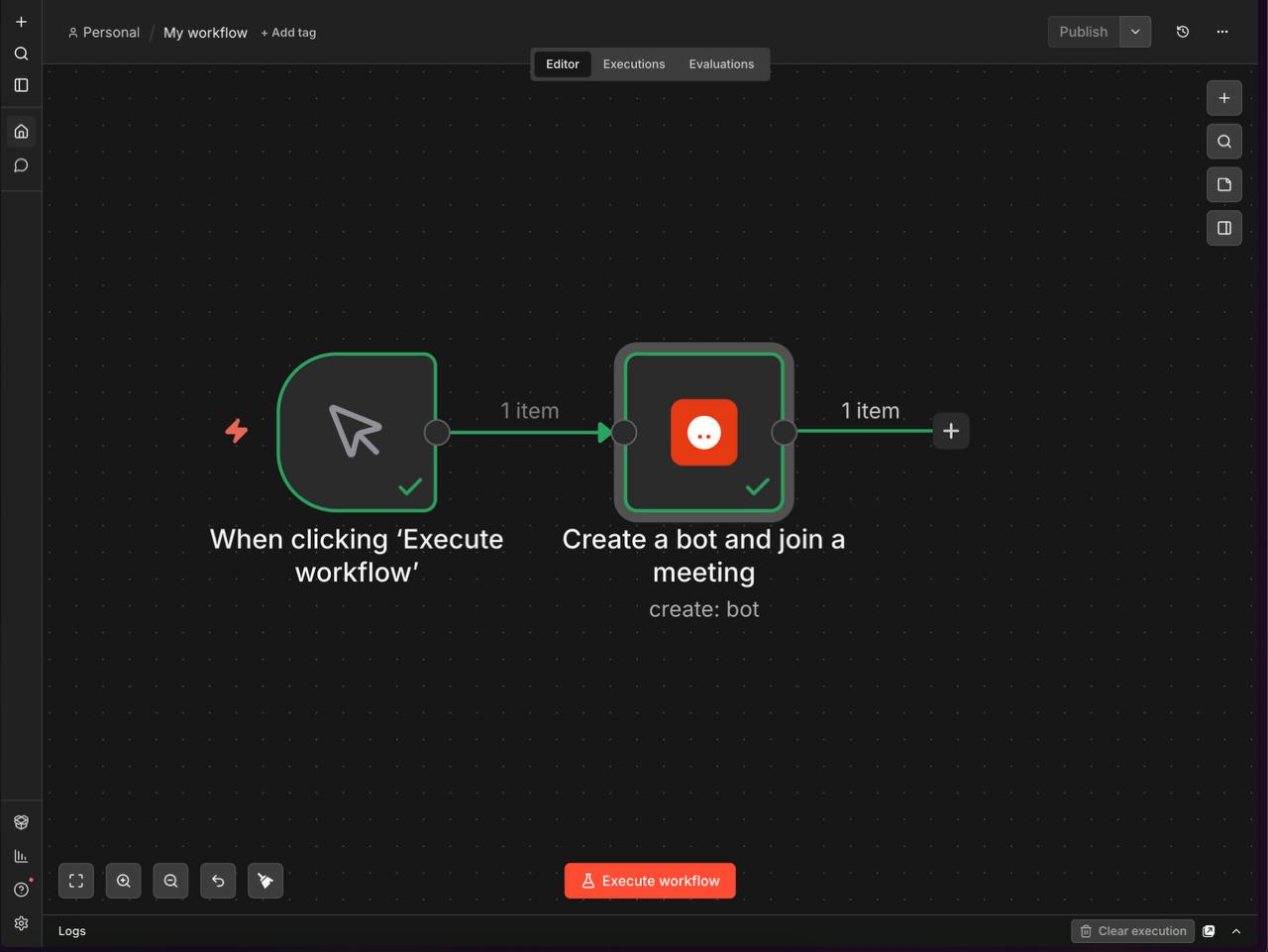

Слева процесс - справа результат

Куда еще можно встроить? Кажется to build - is not a problem anymore, вопрос исключительно в дистрибуции

Продолжаю улучшать Ember - виртуального сотрудника, мне кажется в этом что-то есть.

Теперь она получила свой собственный экран на котором она может показывать данные, рисовать картинки и дедлать вообще что угодно.

Попробуйте сами на clawatar.xyz и расскажите что думаете!