Телеграм канал «Клуб CDO»

телеграм-каналов

рекламных размещений, по приросту подписчиков,

ER, количеству просмотров на пост и другим метрикам

и креативы

а какие хуже, даже если их давно удалили

на канале, а какая зайдет на ура

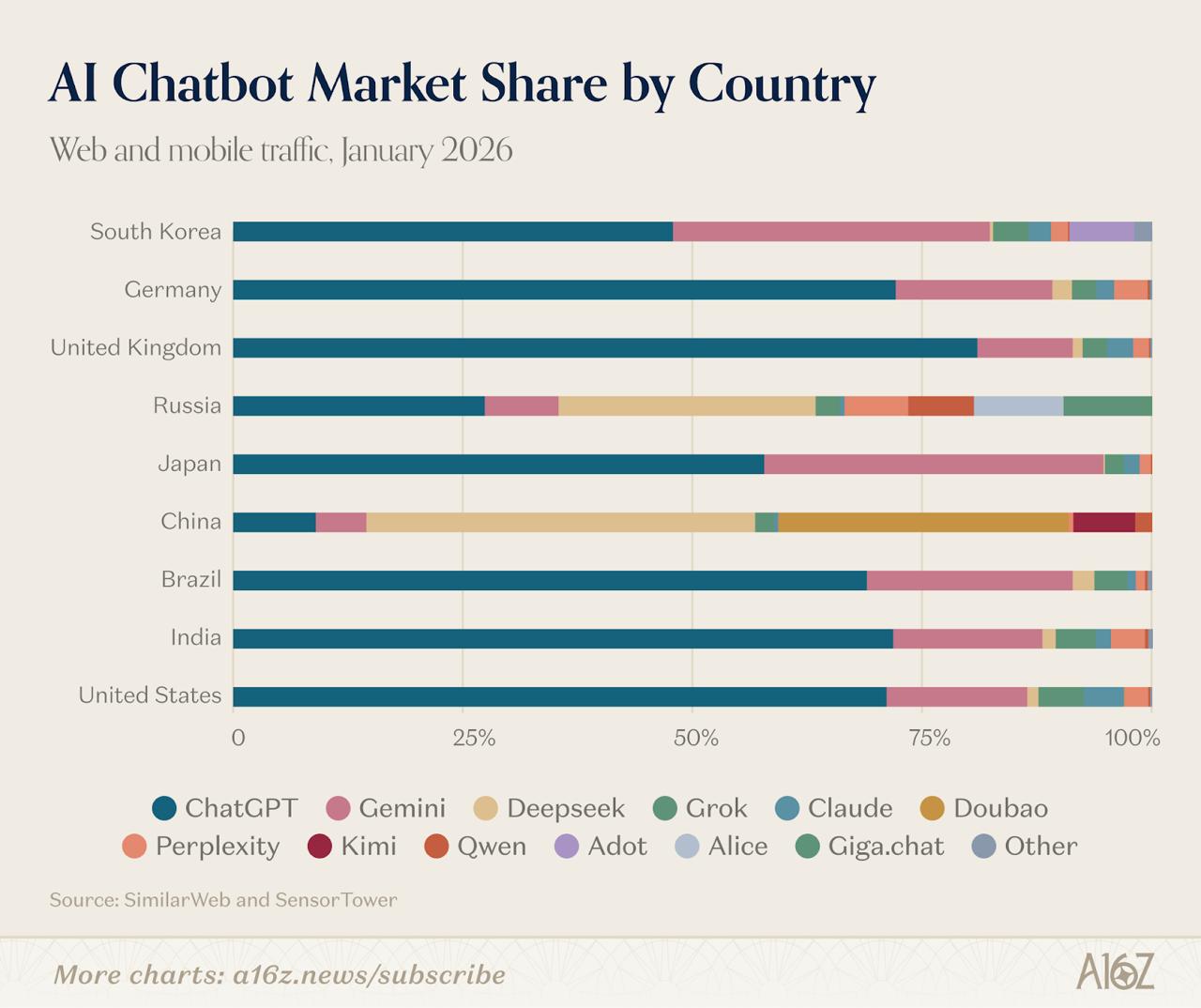

Западные ИИ-сервисы имеют почти одинаковую аудиторию. ChatGPT, Claude, Gemini и Perplexity получают больше всего пользователей из одних и тех же стран: США, Индии, Бразилии, Великобритании и Индонезии. При этом у них почти нет использования в Китае и России.

Китай. Совершенно другие игроки. Doubao (чат-бот от ByteDance), Kimi, DeepSeek, Baidu AI Search, Qwen. Эти продукты почти не представлены на западных рынках. В Китае около 50% рынка чат-ботов с ИИ контролируют местные игроки, о которых большинство западных пользователей никогда не слышали.

Россия, которая раньше не выделялась как отдельный рынок, теперь стала третьим полюсом. Yandex Browser с ИИ-ассистентом Alice достиг 71 млн MAU, войдя в топ-10 мобильных ИИ-продуктов мира. В веб-рейтинге также появился GigaChat от Sber.

**

👉 Не забывайте подписываться на FST

👉 Отзывы о нас

https://youtu.be/onIFwG-5tuE?si=uRirv8tDZxdwJyDS

📰: Architectural Standards for Data Products and AI Interactions: Emergent & Aligned Patterns

Ссылка: https://moderndata101.substack.com/p/architecture-data-products-ai-interactions?publication_id=1170209&post_id=188149190&isFreemail=true&r=15862q&triedRedirect=true

Вывод одной строкой: Успешная архитектура данных и ИИ-продуктов требует применения согласованных паттернов проектирования, которые обеспечивают масштабируемость, надежность и эффективное взаимодействие между компонентами системы через стандартизированные интерфейсы и протоколы обмена данными.

📰: Data Mesh vs централизованная модель: выбираем оптимальный подход к управлению данными

Ссылка: https://habr.com/ru/companies/vk/articles/1005846/

Вывод одной строкой: Выбор между Data Mesh и централизованной моделью управления данными зависит от масштаба организации, сложности доменов, зрелости команд и требований к автономности подразделений, при этом Data Mesh подходит для крупных компаний с множественными доменами данных, а централизованная модель эффективнее для небольших организаций с ограниченными ресурсами.

📰: Почему Lakehouse нельзя построить без Spark

Ссылка: https://habr.com/ru/companies/datasapience/articles/1007428/

Вывод одной строкой: Apache Spark является критически важным компонентом для построения архитектуры Lakehouse, поскольку обеспечивает единую платформу для обработки структурированных и неструктурированных данных с возможностями как пакетной, так и потоковой обработки, что делает его незаменимым для реализации концепции объединения преимуществ озер данных и хранилищ данных.

📰: Корпоративная память как инфраструктура: как мы построили RAG-систему внутри ИТ-компании с промышленной экспертизой

Ссылка: https://habr.com/ru/companies/zyfra/articles/1007356/

Вывод одной строкой: Построение корпоративной RAG-системы требует тщательного планирования архитектуры данных, выбора подходящих методов векторизации и индексации, а также создания эффективных механизмов поиска и ранжирования релевантной информации для обеспечения качественной работы с корпоративными знаниями.

📰: Инструментарий аналитика данных: что реально нужно освоить в 2026 году

Ссылка: https://habr.com/ru/articles/1007780/

Вывод одной строкой: Современному аналитику данных критически важно сосредоточиться на освоении SQL, Python, инструментов визуализации данных и базовых принципов машинного обучения, поскольку эти навыки остаются фундаментальными независимо от появления новых технологий и трендов в области данных.

📰: The Data Team’s Survival Guide for the Next Era of Data | Towards Data Science

Ссылка: https://towardsdatascience.com/the-data-teams-survival-guide-for-the-next-era-of-data/

📰: Data Ownership in Practice: Defining Decision Rights in Enterprise Data Governance

Ссылка: https://moderndata101.substack.com/p/data-ownership-in-practice-defining?publication_id=1170209&post_id=187760032&isFreemail=true&r=15862q&triedRedirect=true

Вывод одной строкой: Эффективное управление корпоративными данными требует четкого распределения прав принятия решений между владельцами данных, их хранителями и потребителями, что обеспечивает качество данных, соблюдение требований безопасности и максимизацию бизнес-ценности информационных активов.

Сразу к ключевому: Claude Code — это легкий shell поверх модели. Вся логика работы формируется не алгоритмами, а самой моделью. Клиент определяет UI, даёт модели набор инструментов для работы с файловой системой и bash — и уходит с дороги. Команда сознательно пишет как можно меньше бизнес-логики. С каждым новым релизом модели они удаляют код — например, с выходом моделей 4.0 вырезали примерно половину системного промпта, потому что модель больше в нём не нуждалась.

Это противоположность тяжёлым agent frameworks с кучей явных состояний, FSM и сложных оркестраторов. И снова я вижу подтверждение: сдвиг парадигмы в пользу "дай задачу", а не "скажи как делать" даёт отличный результат в совокупности с моделями уровня Opus 4.6.

Изначально это был CLI-прототип, который через AppleScript показывал, какую музыку слушает разработчик. Настоящий момент наступил, когда прототипу дали доступ к файловой системе и bash: агент начал сам читать файлы, переходить по импортам и исследовать кодовую базу. Авторы называют это "product overhang" — модель уже умеет нечто мощное, но вокруг этого ещё нет продукта.

Дальше — вирусное распространение внутри Anthropic. Первый день внутреннего релиза — 20% инженеров. Пятый день — 50%. Была серьёзная дискуссия: не оставить ли инструмент как внутреннее преимущество. Решили, что публичный релиз даст больше данных о безопасности модели. Сейчас Claude Code генерирует больше 500 миллионов долларов годовой выручки, а рост использования за три месяца после релиза — больше чем в 10 раз.

Архитектура — подчёркнуто простая. Вместо Docker и VM всё выполняется локально. Самая сложная часть — система разрешений: перед каждым потенциально опасным действием агент спрашивает пользователя. Настройки прав многоуровневые — по проекту, по пользователю, по организации. Команды уже шарят файлы настроек между собой.

Стек выбирали по принципу "on distribution" — TypeScript, React, Ink, Bun. То, что модель уже хорошо знает. Результат: 90% кода Claude Code написано самим Claude Code.

Отдельная история — как выглядит AI-first инженерия в Anthropic. Claude делает первый проход всех код-ревью по компании, пишет security-ревью PR, почти полностью пишет тесты, триажит GitHub-issues и с первой попытки корректно решает 20-40% из них. При инцидентах агент сам подтягивает контакты из Slack, логи из Sentry и часто находит root cause быстрее человека.

Команда из дюжины инженеров делает 60-100 внутренних релизов в день, по 5 PR на инженера. При удвоении размера команды пропускная способность по PR выросла на 67% — обычно при быстром найме этот показатель падает.

Что меня зацепило больше всего: один из инженеров за два дня собрал около 20 рабочих прототипов одной фичи. Не мокапов — рабочих прототипов. Раньше за два дня ты был рад двум. AI-агенты меняют не просто скорость — они меняют саму экономику экспериментирования. А это для product-minded инженера важнее любого фреймворка.

https://newsletter.pragmaticengineer.com/p/how-claude-code-is-built

ИТ-директоров и руководителей-стратегов в управлении данными приглашают на редкий курс — проходит только 1 раз в году в формате живого диалога и обмена опытом.

⚡️ Курс даст понимание, как выстроить ключевые процессы для обеспечения качества, прозрачности и надёжности данных в компании. Участники детально разберут модели, роли, метрики, запуск управления данными и реальные кейсы — в закрытом экспертном сообществе.

В программе курса:

– 9 модулей: от основ Data Governance (DG) до применения ИИ,

– разработка программы DG и системы метрик,

– разбор кейсов + готовый Excel-гайд по DG для вашей компании.

Участники получат:

– домашние задания с обратной связью, консультации с экспертом,

– сертификат участника и доступ к материалам курса.

Ведущий эксперт – Александр Бараков, руководитель департамента бизнес-аналитики в Авито

Забронировать место в потоке 2026 – на курсе осталось всего 5 мест!

Именно в King’s College он за три года получил первый класс по математике, стал Fellow в 23 года и написал работу «On Computable Numbers» — ту самую, где описал абстрактную машину, способную выполнить любое вычисление. По сути, он придумал концепцию компьютера до того, как появилась технология для его создания. Ему было 24.

Потом была Энигма, Блетчли-Парк, тест Тьюринга, основы искусственного интеллекта — всё это знают.

Наткнулся на книгу "Inference Engineering" от Philip Kiely из Baseten. Сам пока не читал, но видел рекомендации от разработчиков, которым я доверяю.

Почему тема важная, особенно для крупных компаний: инференс — это не только про то, как гонять GPT-класса модели на кластерах. Это и про SLM, которые можно запускать ближе к пользователю, дешевле и быстрее. Когда у тебя тысячи запросов в секунду и бюджет не резиновый, умение выжимать максимум из железа на этапе инференса — это прямая экономия. И конкурентное преимущество.

Книга покрывает весь стек: от CUDA и GPU-архитектур до квантизации, speculative decoding и продакшен-инфраструктуры. 256 страниц, 7 глав, без воды.

И главное — она бесплатная. PDF можно скачать прямо на сайте. Когда тебе бесплатно дают структурированное знание по теме, в которой через пару лет будет дефицит специалистов — странно не воспользоваться.

https://www.baseten.co/inference-engineering/