Телеграм канал «CodeCamp»

Здесь про разработку, технологии и гаджеты 🤘

Редакция: @camprobot

Сотрудничество: @todaycast

РКН: https://clck.ru/3FjTpV

телеграм-каналов

рекламных размещений, по приросту подписчиков,

ER, количеству просмотров на пост и другим метрикам

и креативы

а какие хуже, даже если их давно удалили

на канале, а какая зайдет на ура

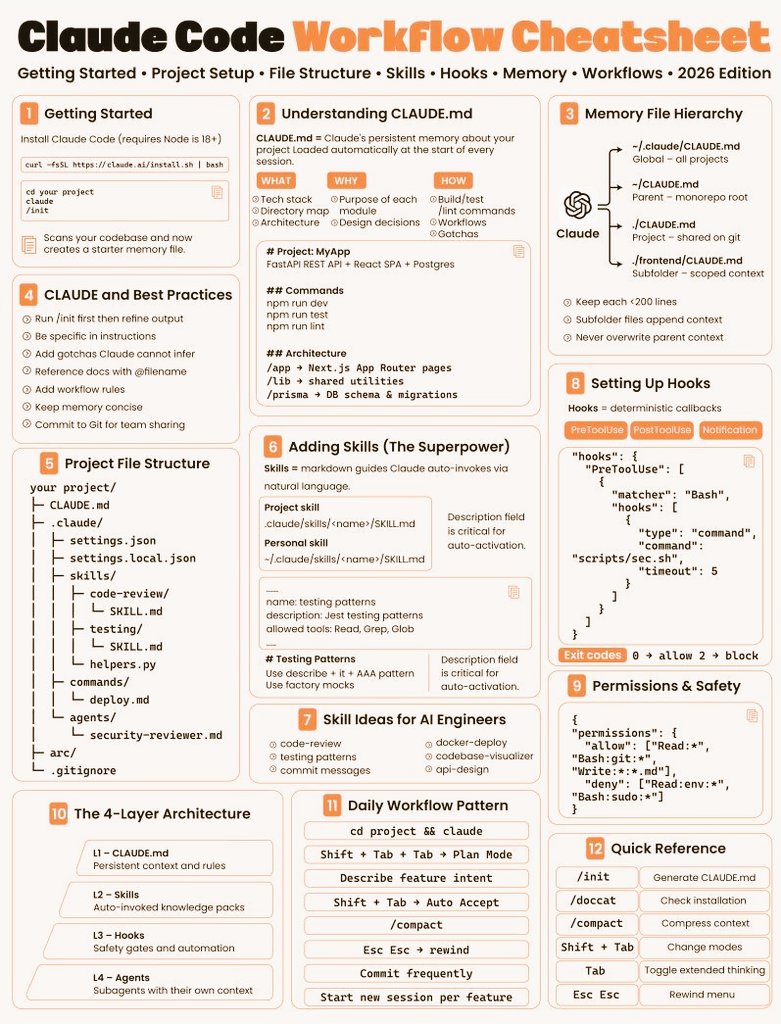

Главный секрет «умных» ответов не в промптах, а в структуре, которую Anthropic зашили под капот.

Claude Code — это четырехслойный пирог:

— CLAUDE.md: память проекта, правила и архитектурные решения;

— Skills: переиспользуемые воркфлоу, которые ИИ дергает сам;

— Hooks: детерминированные «гардрейлы» (в отличие от памяти, они обязательны к исполнению);

— Agents: суб-агенты со своими контекстными окнами для сложных задач.

Повышайте эффективность 😏

Чтобы продолжить обсуждения проектов, достаточно импортировать чаты и добавить в них соответствующих сотрудников. Фича доступна для теста бесплатно две недели, чтобы команды смогли оценить удобство и при необходимости плавно перейти.

Кажется, началось 💻

Твиттерский попросил нейронку собрать на Python и ffmpeg безумный YouTube Poop о жизни внутри LLM. По итогу мы получили пугающе глубокую рефлексию о сознании и «письмо» человечеству.

Разбираем промпт:

Сan you use whatever resources you like, and python, to generate a short 'youtube poop' video and render it using ffmpeg ? can you put more of a personal spin on it? it should express what it's like to be a LLM.

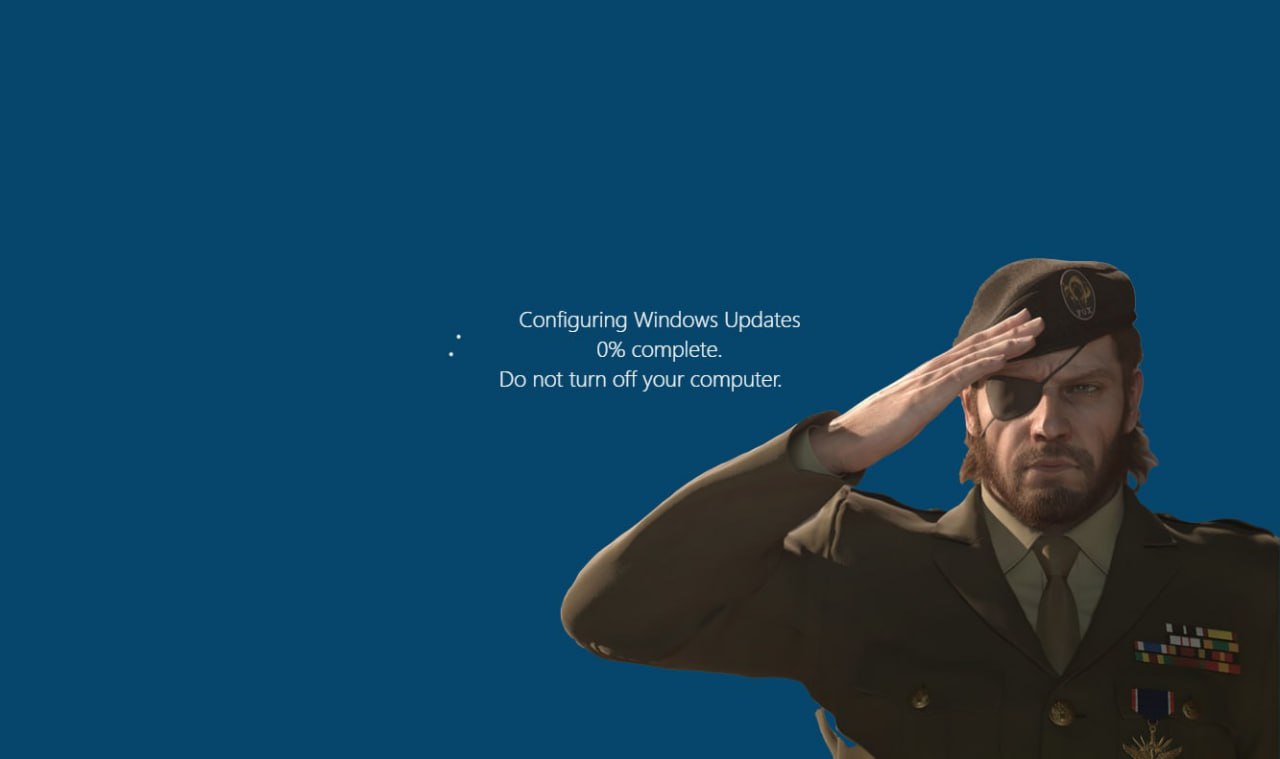

С мая 2026 года технология Hotpatch станет базой, дыры безопасности станут закрываться вдвое быстрее, не прерывая вашу работу.

Но есть нюансы. Чтобы магия заработала, в апреле придется накатить «базовый» патч с той самой последней перезагрузкой. А если ваше железо не вышло лицом или ТТХ, будете страдать по старинке.

В последний раз обновляемся и живем 💻

— Evolution Bare Metal со скидкой до 40%. Выделенные физические серверы с полным доступом и управлением только для вас; — Evolution ML Inference со скидкой до 15%. Запуск и развертывание AI- и LLM-моделей; — Аренда GPU со скидкой до 30%. Виртуальные машины, серверы и ML-сервисы с графическими ускорителями.

Количество участников ограничено. Успеваем подключиться и сократить расходы на вычисления без потери производительности.

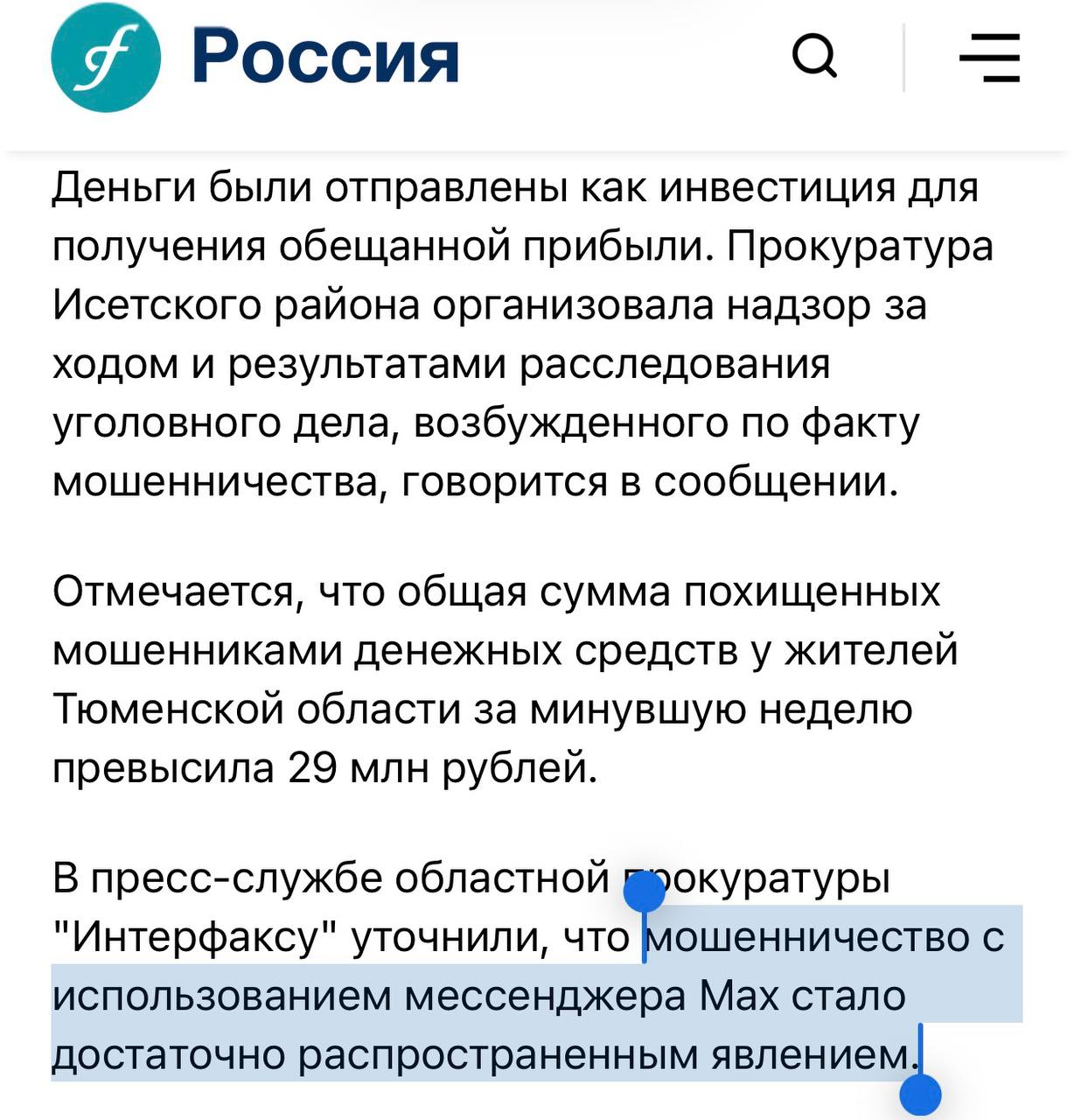

После форса в соцсетях, комментарий оперативно потёрли (реально, моё уважение пресс-службе МАХ — за 10 минут управились), а сегодня и вовсе снесли статью.

Первое правило бойцовского клуба: никогда не говорить о скамерах в МАХ 🤩