Телеграм канал «HCAI // Регулирование ИИ»

телеграм-каналов

рекламных размещений, по приросту подписчиков,

ER, количеству просмотров на пост и другим метрикам

и креативы

а какие хуже, даже если их давно удалили

на канале, а какая зайдет на ура

Около 4️⃣0️⃣0️⃣0️⃣ французских актёров, режиссеров и иных кинодеятелей публично заявили о несанкционированном использовании генеративного ИИ для клонирования их голосов и изображений и потребовали усилить правовую защиту прав исполнителей и правообладателей.

🔎 В обращении воспроизведении голоса и изображения артистов без разрешения описывается как «систематическое разграбление» результатов их труда, а также как риск вытеснения живого труда и давления на менее известных исполнителей, которым сложнее отказываться от невыгодных условий.

Артисты отмечают, что им всё чаще предлагают «сдать» свой образ для рекламных роликов, сгенерированных ИИ вместо реальных съемок, — с заметно меньшим гонораром. Такие предложения касаются не только звезд, но и «сотен менее известных артистов», которые не всегда могут отказаться и «уступают свои права ИИ, рискуя имиджем и будущим».

⚖️ Что требуют артисты:

🔵 усилить правовые механизмы, которые позволят ИИ развиваться без нарушения авторских и смежных прав;

🔵 защитить голос и образ от воспроизведения без согласия;

🔵 обеспечить понятные правила для использования ИИ в киноиндустрии на фоне распространения дипфейков и синтетических медиа.

#France #AI #Deepfakes #Copyright

28 февраля Китай представил первую национальную систему стандартов, которая охватывает всю цепочку и жизненный цикл гуманоидных роботов и так называемого воплощённого ИИ (embodied AI – ИИ, работающий в связке с телом/роботом). Систему представили на ежегодной встрече по стандартизации Humanoid Robots and Embodied Intelligence Standardization (HEIS) в Пекине.

📌 Система стандартов состоит из 6️⃣ блоков:

1️⃣ базовая универсальность;

2️⃣ мозгоподобные и интеллектуальные вычисления;

3️⃣ конечности и компоненты;

4️⃣ комплектные машины и системы (робот целиком);

5️⃣ применение (сценарии использования);

6️⃣ безопасность и этика.

🧠 Стандарты интеллектуальных вычислений, подобные работе мозга, охватывают критически важные спецификации для «мозга и мозжечка» воплощенного интеллекта, регулируя весь жизненный цикл данных, а также процессы обучения и развертывания моделей.

🛠 Отдельные стандарты описывают разработку, эксплуатацию и обслуживание гуманоидных роботов в разных сценариях, а блок «Безопасность и этика» проходит через весь жизненный цикл и должен обеспечивать «комплаенс» по мере эволюции технологий.

🏛 Система подготовлена при координации профильного техкомитета Министерства промышленности и информатизации Китая и собрана усилиями 120+ исследовательских организаций, компаний и промышленных пользователей.

Отдельно подчёркивается рост сектора в 2025 году: его поддерживали национальные и региональные планы, а 2025-й в Китае называют первым годом массового производства гуманоидных роботов – 1️⃣4️⃣0️⃣➕ производителей представили 3️⃣3️⃣0️⃣➕ моделей.

Ожидается, что новая система стандартизации станет важным ориентиром для этой быстро развивающейся отрасли, способствуя высококачественному развитию за счет стандартизированных технических требований и протоколов безопасности.

#China #AI #Robotics #EmbodiedAI #Standards #Safety #Ethics #Regulation

1️⃣ В Китае презентовали первую национальную систему стандартов, которая охватывает всю производственную цепочку и жизненный цикл человекоподобных роботов и воплощенного ИИ.

2️⃣ Более 60 органов по защите данных из разных стран подписали совместное заявление, в котором выразили обеспокоенность стремительным распространением сексуализированных дипфейков.

3️⃣ На фоне конфронтации Пентагона и Anthropic Трамп приказал федеральным ведомствам не применять разработки компании.

4️⃣ Во Франции 4 тысячи деятелей культуры подписали открытое письмо с призывом ограничить использование их голосов и образов с помощью ИИ.

5️⃣ Губернатор Пенсильвании поручил запустить правительственную группу AI Enforcement Task Force, чтобы расследовать случаи, когда ИИ-чатботы выдают себя за психотерапевтов и занимаются нелицензированной практикой.

1️⃣ Владимир Путин подписал указ о создании комиссии по развитию ИИ при президенте России.

2️⃣ Михаил Мишустин заявил, что подготовлен законопроект с критериями для моделей ИИ, применяемых в государственных информационных системах и на объектах критической инфраструктуры, и его планируют обсуждать в весеннюю сессию Госдумы. Также, по его словам, прорабатывается национальный план внедрения ИИ.

3️⃣ Президент России поручил принять меры по ускоренному внедрению автономных систем в различных секторах экономики, а Москве рекомендовал провести обмен опытом с другими регионами по применению таких решений и ИИ.

4️⃣ Группа сенаторов разработала законопроект, который позволит упростить запуск экспериментальных правовых режимов с ИИ.

5️⃣ В Минцифры совместно с отраслью обсуждается идея обязать разработчиков российских ИИ-моделей раскрывать сведения о датасетах обучения и тестирования.

15 февраля правительство Индии опубликовало «India AI Governance Guidelines», который фиксирует подход страны к управлению ИИ и отдает приоритет инновациям перед ограничительными мерами, рассматривая ИИ как катализатор инклюзивного роста и конкурентоспособности..

🎯 Цель документа – максимально масштабировать инклюзивное развитие и внедрение ИИ во все сферы жизни, не создавая излишних правовых барьеров, так, чтобы не допустить концентрации ИИ у нескольких компаний.

🔍 Документ закрепляет следующий технико-правовой подход: многие риски можно закрывать существующими законами, но при этом необходим анализ пробелов — где не хватает понятий, ответственности и инструментов контроля по всей цепочке разработки и внедрения ИИ.

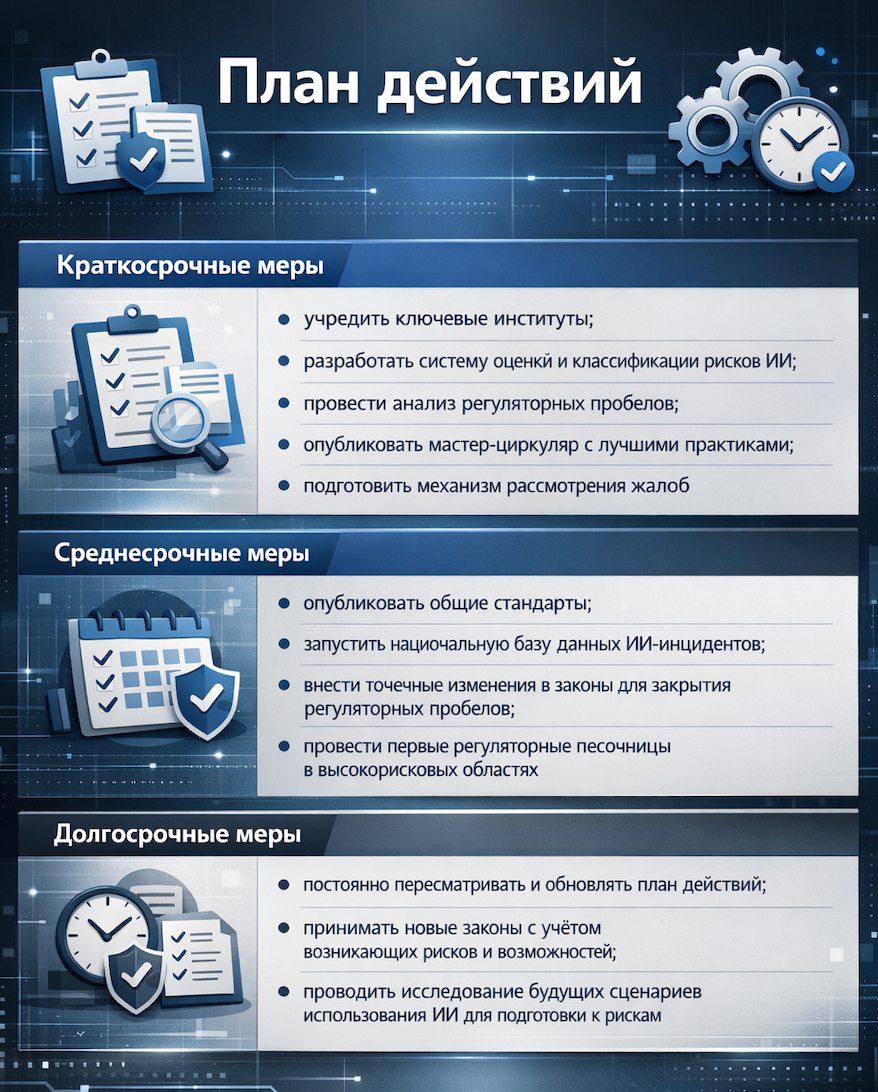

India AI Governance Guidelines состоит из 4️⃣ частей: принципы, ключевые проблемы, план действий и практические рекомендации.

7️⃣ «сутр» — принципы, на которых должно строиться универсальное управление ИИ:

1️⃣ Доверие как основа внедрения ИИ

2️⃣ Человекоцентричность

3️⃣ Инновации важнее ограничений

4️⃣ Справедливость и равенство

5️⃣ Подотчётность

6️⃣ Понятность заложена в дизайн

7️⃣ Безопасность, устойчивость и экологичность

⛔️ В документе детально отражены ключевые препятствия для развития ИИ и соответствующие меры по их преодолению. Так, для решения задач в части регулирования, подотчетности и снижения рисков ИИ предусмотрены следующие меры:

✅ принять гибкую сбалансированную структуру управления ИИ с опорой на действующее законодательство;

✅ сделать обзор текущего правового поля, чтобы выявить ИИ-риски и регуляторные пробелы;

✅ уточнить применение существующих законов к ИИ-разработчикам через пояснительные записки;

✅ внести точечные поправки в законодательство по чувствительным вопросам (например, в части защиты данных);

✅ развивать регуляторные песочницы;

✅ разработать общие стандарты для проверки подлинности контента;

✅ создать индийскую систему классификации рисков и национальный механизм отчётности об инцидентах ИИ.

🏛 Для преодоления ключевых проблем предлагается создать новые институты:

🔵 Группа по управлению ИИ – координация политики ИИ с национальными приоритетами;

🔵 Экспертный комитет по технологиям и политике – предоставление рекомендаций Группе по управлению ИИ;

🔵 Институт безопасности ИИ - проведение исследований, разработка стандартов и методов тестирования.

✍️ План действий содержит поэтапную дорожную карту институционализации управления ИИ, смягчения рисков и устойчивого внедрения во всех секторах (подробности во вложении).

⚙️ Практические рекомендации:

🔵 разработчикам и поставщикам ИИ рекомендуется действовать в соответствии с существующими законами Индии;

🔵 регуляторам рекомендуют выбирать наименее обременительные меры и только там, где есть угроза причинения реального вреда.

Таким образом, руководящие принципы управления ИИ в Индии описаны как прагматичный, сбалансированный и гибкий инструмент, продвигающий безопасное, заслуживающее доверия и ответственное развитие и внедрение ИИ.

#India #AI #Governance #Safety #Regulation

🇪🇺 Европейский союз

11 февраля Комитет по правовым вопросам Европарламента одобрил предложения по тому, как защищать правообладателей при обучении генеративного ИИ.

🔎 Ключевые идеи:

🔵 правообладатели должны иметь возможность запретить использование их контента для обучения, в т. ч. путем веб-скрейпинга;

🔵 провайдеры ИИ-систем должны обеспечить прозрачность использования охраняемых произведений (вести специальный перечень);

🔵 контент, полностью созданный ИИ, не должен защищаться авторским правом;

🔵 вознаграждение авторам и правообладателям должно быть «справедливым»;

🔵 депутаты просят Комиссию изучить, может ли компенсация распространяться и на прошлые случаи использования контента;

🔵 комитет отверг идею «глобальной лицензии» за фиксированную плату.

Депутаты считают, что право ЕС должно применяться ко всем системам генеративного ИИ, доступным на рынке Европейского союза, независимо от того, где проходит обучение моделей.

Дальше документ как инициативный доклад вынесут на голосование Европарламента на пленарной сессии в марте.

🇺🇸 Соединенные Штаты Америки

10 февраля Сенаторы Адам Шифф и Джон Кёртис представили законопроект – CLEAR Act (Copyright Labeling and Ethical AI Reporting Act) – про обязательное раскрытие данных об обучении моделей.

📌 Что предлагают:

🔵 перед выпуском ИИ-модели компании должны подать Регистратору авторских прав США достаточно детализированное описание каждого охраняемого произведения в датасете;

🔵 требования хотят сделать ретроспективным для уже доступных продуктов;

🔵 Бюро авторского право США должен будет создать публичную базу данных таких уведомлений;

🔵 за нераскрытие информации – гражданско-правовые санкции.

Законопроект при этом не требует от ИИ-компаний обязательного лицензирования охраняемых произведений для обучения моделей.

❗️Эксперты предупреждают, что требования «полной прозрачности» по использованным датасетам на практике могут оказаться трудноисполнимыми — особенно для больших моделей, обученных на огромных массивах данных, при этом многократно обновляемых. Комплаенс станет дорогим и бюрократичным, что ударит по стартапам, — то есть меры, задуманные для защиты авторов, могут одновременно замедлить темпы инноваций и повысить барьеры входа на рынок.

#AI #Copyright #IP #Regulation #EU #USA #GenAI

1️⃣ Генеральный секретарь ООН призвал при поддержке Генассамблеи создать Глобальный фонд по ИИ для наращивания базового потенциала в развивающихся странах.

2️⃣ Администрация президента США выступила против законопроекта штата Юта, который обязывает разработчиков моделей ИИ внедрять меры безопасности, назвав инициативу противоречащей политике Белого дома.

3️⃣ Правительство Индии представило первые комплексные рекомендации по управлению ИИ, выбрав регулирование через систему принципов и действующее законодательство, а не создание нового специального закона.

4️⃣ Премьер-министр Великобритании Кир Стармер заявил, что правительство внесет изменения в Online Safety Act, чтобы распространить его на ИИ-чат-ботов, и запустит консультации об ограничении доступа детей к таким системам.

5️⃣ Белый дом объявил о запуске инициативы Tech Corps — программе, которая будет отправлять технических добровольцев внедрять американские решения ИИ в странах-партнёрах.