Телеграм канал «Machinelearning»

Показываем как запускать любые LLm на пальцах.

По всем вопросам - @haarrp

@itchannels_telegram -🔥best channels

Реестр РКН: clck.ru/3Fmqri

телеграм-каналов

рекламных размещений, по приросту подписчиков,

ER, количеству просмотров на пост и другим метрикам

и креативы

а какие хуже, даже если их давно удалили

на канале, а какая зайдет на ура

NVIDIA обучила семейство моделей Nemotron-Terminal для автономной работы в терминале Linux: устанавливать зависимости, писать и запускать код, отлаживать окружения и выполнять сквозные инженерные задачи без участия человека.

Семейство построено на базе Qwen3 и специально собранном датасете Terminal-Corpus. И фишка не в архитектуре, а в данных.

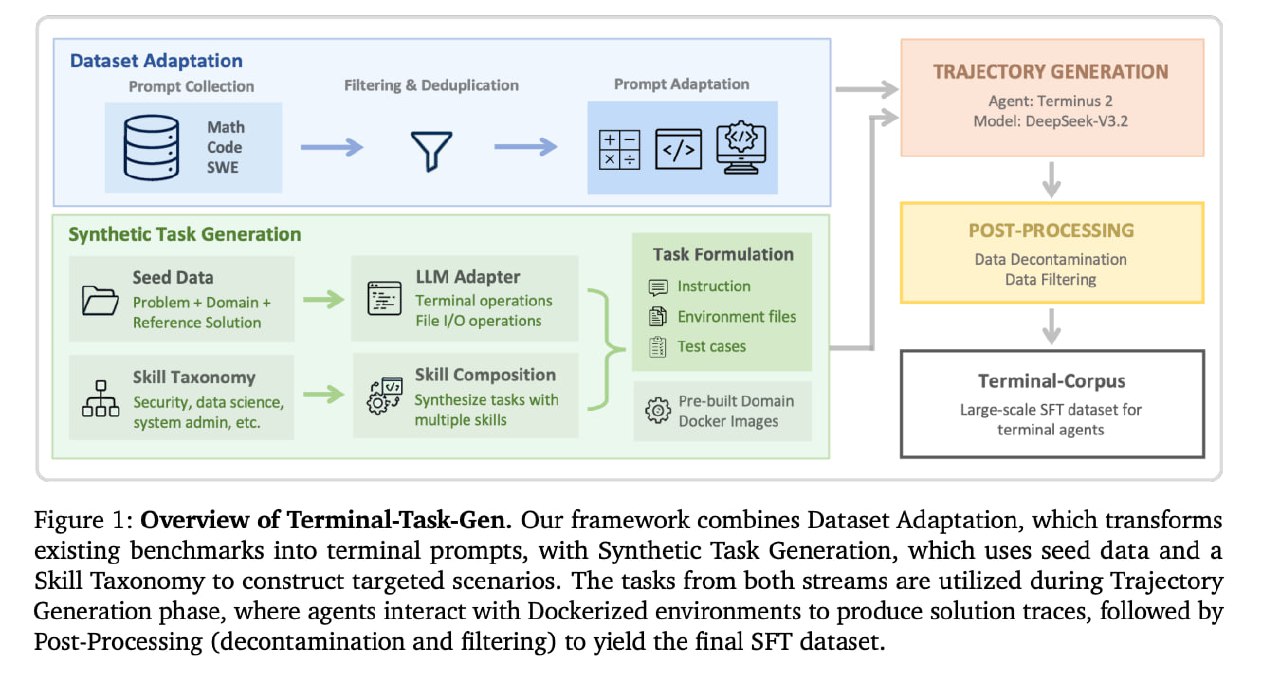

🟡NVIDIA собрала пайплайн Terminal-Task-Gen с 2 потоками.

Первый адаптирует готовые датасеты по математике, коду и SWE-задачам под терминальный формат (без участия LLM в процессе адаптации).

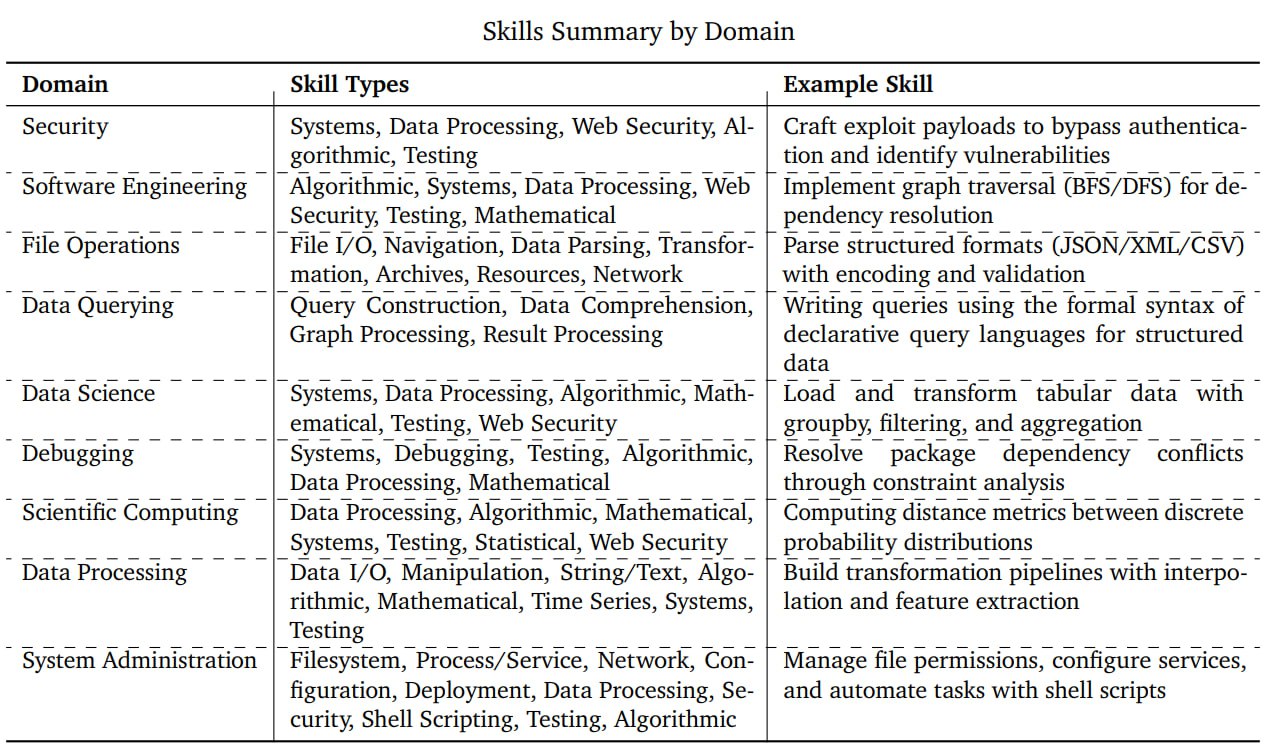

Второй генерирует синтетику 2 методами: seed-based (LLM создает новые задачи на основе существующих задач из смежных областей) и skill-based (LLM комбинирует до пяти примитивных навыков из таксономии по 9 доменам: Security, Data Science, System Administration и другим).

🟡В открытый релиз вошли все три модели на 8B, 14B, 32B параметров и 2 датасета:

Terminal-Corpus: около 366K траекторий выполнения задач, разбитых на два потока: ~226K адаптированных примеров из Math/Code/SWE и ~140K синтетических задач на основе skill-таксономии.

Synthetic-Tasks: задачи в стандартизированном формате: инструкция, Docker-окружение из 9 преднастроенных образов и верификационный набор на pytest.

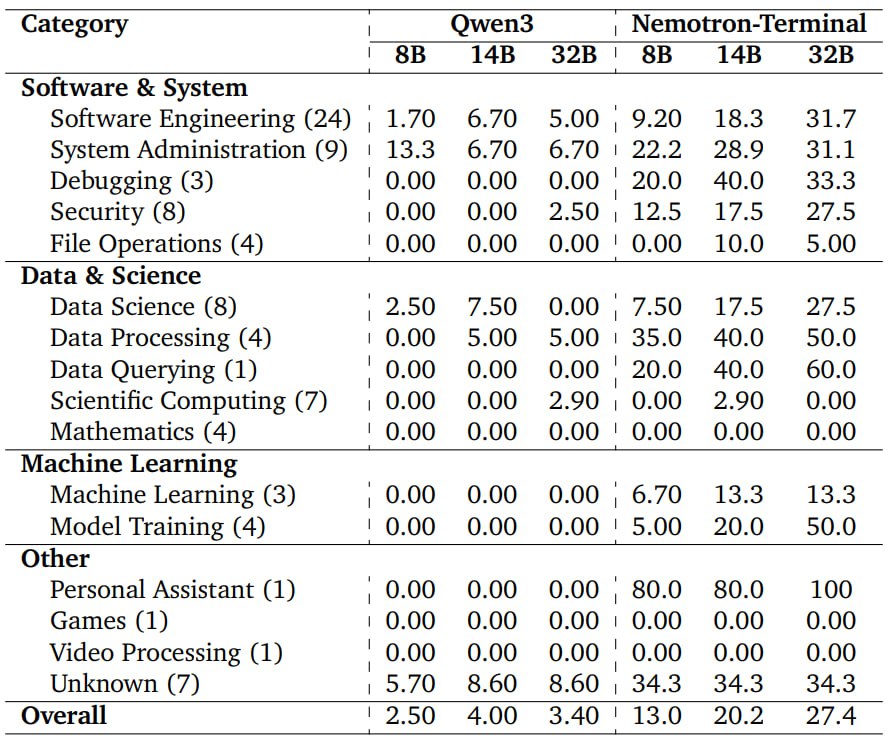

🟡Результаты прогонов на бенчах.

На Terminal-Bench 2.0 все 3 модели показали кратный рост относительно базовой Qwen3: 8B - с 2.5% до 13%, 14B - с 4% до 20.2%, 32B - с 3.4% до 27.4%.

Для сравнения: Qwen3-Coder на 480B параметров набирает 23.9%, GPT-5-Mini - 24.0%, Grok 4 - 23.1%. Nemotron-Terminal-32B превосходит или вплотную конкурирует с ними всеми при разнице в размере на порядок.

🟡Несколько внезапных выводов из абляции.

Фильтрация неудачных траекторий вредит. Модель, обученная на всех траекториях включая ошибочные, набирает 12.4% против 5.06% у варианта только с успешными.

Curriculum learning (сначала простые данные, потом сложные) не дал преимуществ перед простым смешанным обучением.

Увеличение контекстного окна с 32K до 65K токенов также не помогло, длинные траектории оказались шумнее.

📌Лицензирование моделей: NVIDIA Open Model License

📌Лицензирование датасетов : CC-BY-4.0 License.

🟡Набор моделей

🟡Arxiv

@ai_machinelearning_big_data

#AI #ML #LLM #NemotronTerminal #NVIDIA

Провайдер Cloud.ru дает скидки до 40% на ключевые сервисы для запуска и масштабирования AI-проектов.

GPU, физические серверы, ML-инференс — все в одном месте и на выгодных условиях. Минимум лишних затрат, максимум производительности.

Количество участников ограничено — успейте подключиться.

Связанное с КСИР иранское агентство Tasnim опубликовало список объектов для возможных будущих ударов. В него впервые официально вошла ближневосточная инфраструктура американских IT-гигантов: Google, Amazon, Microsoft, NVIDIA, IBM и Oracle. Под угрозой оказались региональные офисы компаний, дата-центры и исследовательские лаборатории.

Иранская сторона объясняет этот шаг тем, что вычислительная инфраструктура корпораций тесно связана с военными и экономическими операциями США и Израиля. По заявлению агентства, текущие региональные конфликты перерастают в полноценные инфраструктурные войны, в связи с чем список потенциальных IT-мишеней будет постепенно расширяться.

aljazeera.com

✔️ Microsoft вступилась за Anthropic в споре с Пентагоном.

Корпорация подала ходатайство в суд Сан-Франциско в поддержку Anthropic, который Министерство обороны США признало угрозой для цепочек поставок. Microsoft просит суд заморозить решение Пентагона и наложить временный запрет на блокировку текущих государственных контрактов.

По заявлению Microsoft, немедленный запрет на использование технологий Anthropic вынудит IT-компании экстренно перестраивать архитектуру своих продуктов. Это грозит серьезными сбоями в работе ИИ-инструментов, которые уже внедрены и активно используются американскими военными. Временная отсрочка позволит избежать хаоса и обеспечит более безопасный переходный период для оборонного ведомства.

Действия Microsoft продиктованы прямым финансовым интересом. В ноябре корпорация объявила о планах вложить в Anthropic до 5 млрд. долларов, параллельно оставаясь ключевым инвестором их главного конкурента - OpenAI.

cnbc.com

✔️ NVIDIA выпустила открытую модель Nemotron 3 Super.

Модель на 120В на архитектуре МоЕ с 12 млрд. активных параметров была создана специально для автономных агентов, выполняющих сложные многоступенчатые задачи. Под капотом гибрид из слоев Mamba, которые экономят память, и классических трансформеров, отвечающих за глубокий логический вывод.

Модель получила контекстное окно на 1 млн. токенов. Дополнительно внедрена функция мульти-токеновой генерации, ускоряющая выдачу результатов в 3 раза.

Nemotron 3 Super под открытой лицензией NVIDIA доступна на HuggingFace. Ее интеграцию уже начали Perplexity, Palantir, Siemens и другие крупные IT-компании.

developer.nvidia.com

✔️ Perplexity анонсировала автономную ИИ-систему на базе Mac mini.

ИИ-поисковик предложил концепцию агента, который работает круглосуточно без участия пользователя. Personal Computer интегрируется с локальными файлами и приложениями на выделенном Mac mini, автономно выполняя сложные рабочие процессы. Система построена на гибридной архитектуре: взаимодействие с десктопом происходит локально, а тяжелые вычисления перенесены на серверы Perplexity.

Ядро платформы - собственный движок оркестрации, который автоматически переключается между передовыми моделями для решения задач. Контролировать ИИ-помощника можно удаленно с любого устройства. Особое внимание уделили безопасности: внедрены функция экстренного отключения, ведение детального аудита всех сессий и ручное подтверждение для чувствительных действий системы. Записаться в лист ожидания проекта можно по ссылке.

PerplexityAI в сети Х

✔️ Anthropic запустила свой исследовательский институт.

Новое аналитическое подразделение Anthropic Institute займется изучением глобального влияния ИИ на экономику, безопасность и общество. Возглавил инициативу сооснователь стартапа Джек Кларк. Институт сфокусируется на трансформации рынка труда, рисках злоупотребления технологиями, а также на механизмах сохранения человеческого контроля над саморазвивающимися ИИ-системами.

В команду вошли около 30 специалистов из существующих отделов Anthropic, включая группу стресс-тестирования Frontier Red Team. К проекту уже присоединились бывшие исследователи из Google DeepMind и OpenAI.

anthropic.com

@ai_machinelearning_big_data

#news #ai #ml

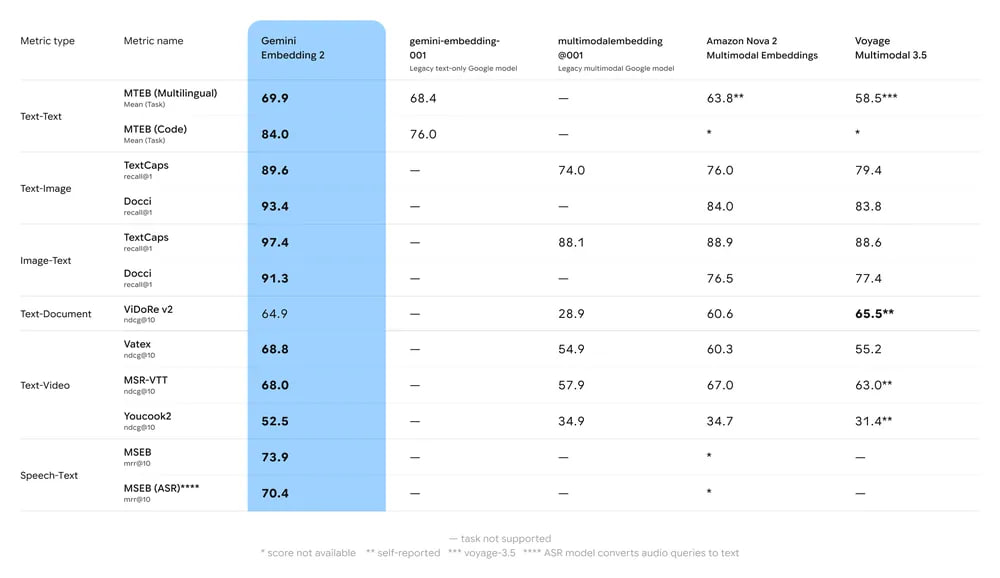

Gemini Embedding 2 - первая нативно мультимодальная эмбеддинг-модель, в которой один запрос может содержать сразу несколько типов данных: например, изображение плюс текст, которые модель обрабатывает совместно, улавливая смысловые связи между разными форматами. Заявлена поддержка более 100 языков.

По параметрам:

🟢Текст: до 8 192 токенов;

🟢Изображения: до 6 штук в запросе (PNG, JPEG);

🟢Видео: до 120 секунд (MP4, MOV);

🟢PDF: до 6 страниц;

🟢Аудио понимает напрямую, без промежуточной транскрибации.

Размерность векторов по умолчанию - 3072, но за счет Matryoshka RL можно снизить до 1536 или 768, жертвуя частью точности ради экономии памяти и ускорения поиска.

Это та же техника вложенных представлений, которую Google использовала в предыдущих моделях и теперь она работает с мультимодальными данными.

Новинка доступна через Gemini API и Vertex AI в режиме Public Preview.

Из коробки работает с LangChain, LlamaIndex, Haystack, Weaviate, Qdrant и ChromaDB.

На GitHub можно найти Notebook-примеры для Gemini и Vertex, а тут - попробовать демо многомодального семантического поиска.

@ai_machinelearning_big_data

#news #ai #ml

OpenAI внедрила в ChatGPT динамические визуальные объяснения для более чем 70 математических и естественно-научных концепций. Пользователи получили возможность на лету менять переменные и мгновенно отслеживать, как новые значения влияют на итоговые графики и формулы.

На данный момент инструмент охватывает в основном школьную и университетскую программу. Среди уже доступных тем: квадрат бинома, экспоненциальный распад, закон Ома, сложные проценты и тригонометрические тождества.

Новая функция открыта для всех пользователей по всему миру. В дальнейшем OpenAI планирует расширить обучающие модули, добавив поддержку новых дисциплин.

openai.com

✔️ Nvidia выделит 1 ГВт мощностей ИИ-стартапу Миры Мурати.

Thinking Machines Lab, основанный бывшим топ-менеджером OpenAI Мирой Мурати, заключил стратегическое партнерство с Nvidia. По условиям соглашения компания получит доступ как минимум к одному гигаватту вычислительных мощностей на базе новейших систем Vera Rubin. Эти ресурсы необходимы для тренировки собственных ИИ-моделей стартапа. Развертывание кластеров начнется в начале следующего года.

Помимо предоставления аппаратной базы, Nvidia увеличила свою финансовую долю в проекте. Ранее чипмейкер уже участвовал в раунде на 2 млрд. долларов, по итогам которого Thinking Machines Lab оценили в 12 миллиардов.

Компании будут совместно разрабатывать инфраструктуру для обучения и деплоя нейросетей, чтобы открыть доступ к передовым ИИ-решениям для бизнеса и научного сообщества.

blogs.nvidia.com

✔️ Amazon обязал инженеров проверять сгенерированный ИИ код.

Руководство Amazon ввело новое правило: теперь любые изменения в коде, написанные с помощью ИИ, должны проходить обязательное ревью у старших инженеров перед деплоем. Решение приняли после череды критических инцидентов, которые в компании охарактеризовали как сбои с "большим радиусом поражения".

Старший вице-президент Дэйв Тредвелл созвал сотрудников на специальное совещание для разбора причин деградации сервисов. В Amazon признали, что надежные практики и механизмы защиты при работе с код-генераторами в индустрии пока не сформированы. До тех пор ручной фильтр в виде экспертизы опытных разработчиков останется для компании главной страховкой от новых масштабных падений продакшена.

ft.com

✔️ Nvidia делает open-source платформу NemoClaw.

Nvidia готовится запустить NemoClaw - открытую платформу, которая позволит разработчикам корпоративного ПО создавать и развертывать автономных ИИ-агентов. Фишка проекта в том, что он не требует привязки к железу Nvidia. Ожидается, что официальный анонс состоится на грядущей конференции в Сан-Хосе. Компания уже ведет переговоры о раннем доступе с Salesforce, Google, Cisco, Adobe и CrowdStrike.

Выпуск open-source решения стратегически важный шаг для Nvidia. Компания стремится выйти за рамки своей экосистемы CUDA, чтобы сохранить лидерство в ИИ-инфраструктуре на фоне того, как крупные IT-гиганты проектируют собственные кастомные чипы.

wired.com

✔️ Cortical Labs запустила первые дата-центры.

Cortical Labs, о котором мы рассказывали недавно, открыл в Мельбурне первый биологический дата-центр и готовится к запуску второй площадки в Сингапуре. Вместо традиционных серверов в ЦОДах используются биокомпьютеры CL1.

Их вычислительным ядром выступают выращенные из человеческих клеток нейроны, размещенные на специальных чипах. Аппаратная часть обменивается с биоматериалом электрическими сигналами, а программное обеспечение интерпретирует реакции клеток как результаты вычислений.

До прямой конкуренции с классическими процессорами еще далеко, но стартап демонстрирует уверенный прогресс. В мельбурнском центре уже размещены 120 установок, а сингапурский кластер в перспективе планируют масштабировать до тысячи биомодулей.

bloomberg.com

@ai_machinelearning_big_data

#news #ai #ml

OpenAI объявила о приобретении Promptfoo, платформы для тестирования безопасности и оценки ИИ-систем. После закрытия сделки технологии компании войдут в продукт Frontier, корпоративную платформу для создания и эксплуатации ИИ-агентов.

Promptfoo основали Иан Уэбстер и Майкл Д'Анджело в 2024 году За неполные два года команда создала CLI-инструмент с открытым исходным кодом и набор решений, которые используют более 25% компаний из списка Fortune 500. Основная специализация — оценка поведения LLM-приложений и контролируемые попытки взломать систему, чтобы найти уязвимости до того, как это сделают злоумышленники.

Интеграция с Frontier предполагает 3 направления.

🟢Встроенное security-тестирование. Автоматические проверки на prompt injection, jailbreak, утечки данных и нецелевое использование инструментов станут нативной частью платформы.

🟢Интеграция в dev-workflows - выявлять и устранять риски можно будет прямо в процессе разработки, не откладывая безопасность на финальный этап.

🟢Аудит и комплаэнс. Встроенная отчетность поможет командам документировать тестирование и выполнять требования по управлению ИИ-рисками.

Решение о покупке основано на том, что по мере того как агенты получают доступ к реальным данным и бизнес-системам, цена ошибки резко возрастает.

Стандартных метрик качества явно недостаточно, бизнесу нужны систематические инструменты для верификации поведения агентов в нештатных ситуациях. Promptfoo именно этим и занималась, причем в open-source-формате.

OpenAI обещает продолжать развивать open-source составляющую Promptfoo параллельно с интеграцией в Frontier.

Сумма сделки не раскрывается, но по открытым данным, в июле прошлого года стартап оценили в 86 млн. долларов.

@ai_machinelearning_big_data

#news #ai #ml

Недавний мем о том, что теперь спонсоры не берутся за проекты без AI — уже не мем, а реальность. Почти в каждом приложении/продукте теперь есть встроенные нейронки, агенты, тулсы. Другой вопрос: какой это дает профит и как этот профит вообще посчитать.

Через 5 дней Яндекс соберет на своем митапе руководителей и инженеров крупных IT-компаний, которые расскажут, как оценивать реальную эффективность AI.

Все выступления спикеров поделили на 2 тематических блока. Первый — про опыт внедрения, метрики и влияние AI на продуктивность и качество. Второй — про построенные мультиагентные системы, внутренние продукты и конкретные рабочие инструменты, которыми уже можно пользоваться.

Лидер трека AI в разработке Яндекса Андрей Попов объяснит, на какие метрики смотреть при оценке эффективности, и покажет, каких результатов они достигли. А еще расскажет, как компания использует AI для тестирования, оптимизации процессов и работы с инцидентами. В этой же части — выступление руководителя продуктовой аналитики в управлении базовых технологий в Т-Банке про оценку эффективности в SDLC.

Во втором блоке Сергей Бульдяев, технический менеджер продукта в Яндексе, представит кейсы агента в IDE на базе open-source решения, а Максим Шведенко, руководитель направления Департамента недвижимости и эксплуатации в Сбере, объяснит из чего состоит мультиагентная система для дизайнеров.

Митап пройдет в Москве, а для тех, кто в другом городе, будет онлайн-трансляция. Зарегистрироваться на ивент можно тут.